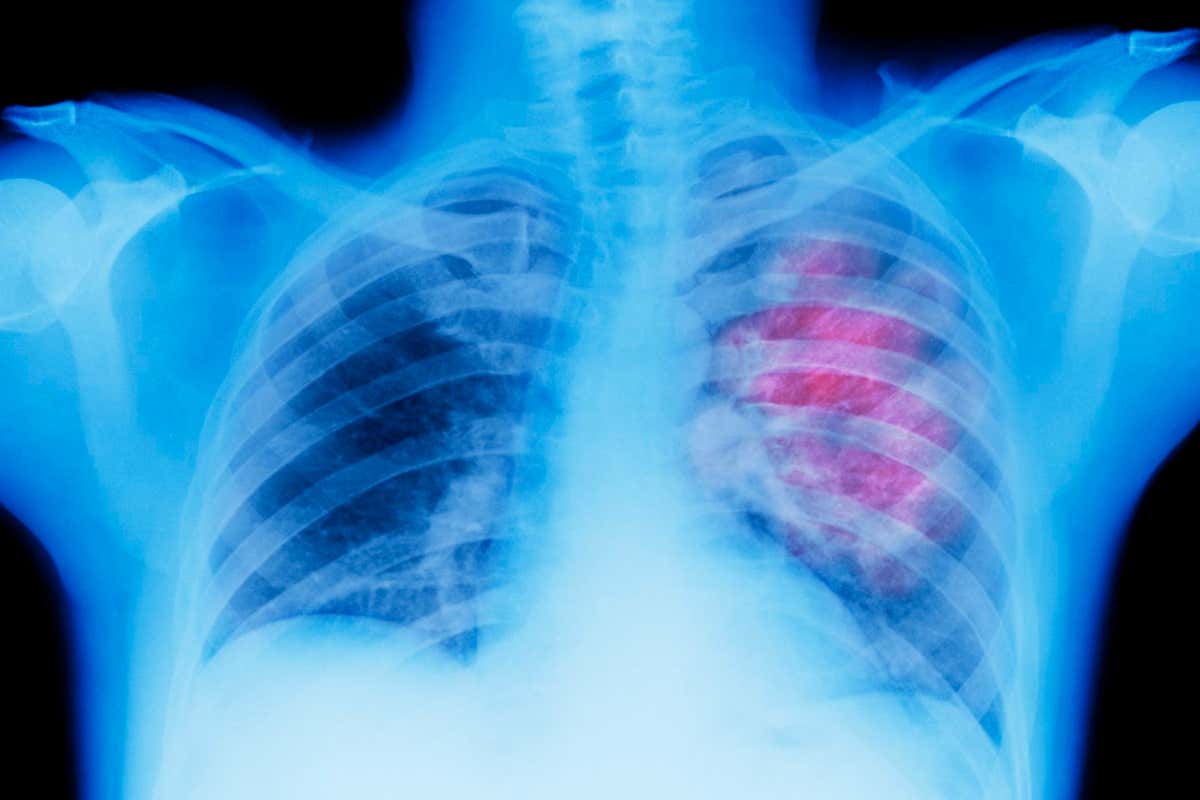

Las IA médicas pueden diagnosticar enfermedades a partir de imágenes como rayos X, pero generalmente no juzgan cuándo pueden estar equivocadas.

Peter Dazeley/El banco de imágenes de RF/Getty Images

Un nuevo sistema de inteligencia artificial desarrollado por Google puede decidir cuándo confiar en las decisiones basadas en IA sobre diagnósticos médicos y cuándo derivar a un médico humano para una segunda opinión. Sus creadores afirman que puede mejorar la eficiencia del análisis de datos de escaneo médico, reduciendo la carga de trabajo en un 66 % y manteniendo la precisión, pero aún no se ha probado en un entorno clínico real.

El sistema, el flujo de trabajo de defer-to-clinic (CoDoC) basado en la complementariedad, funciona ayudando a la IA predictiva a saber cuándo no sabe algo, evitando problemas con las últimas herramientas de IA que pueden inventar hechos cuando no son confiables. respuestas

Está diseñado para funcionar con los sistemas de IA existentes, que a menudo se utilizan para interpretar imágenes médicas como radiografías de tórax o mamografías. Por ejemplo, si una herramienta de IA predictiva analiza una mamografía, CoDoC juzgará si la confianza percibida de la herramienta es lo suficientemente fuerte como para confiar en un diagnóstico o si involucrar a un ser humano en caso de incertidumbre.

En una prueba teórica del sistema realizada por sus desarrolladores en Google Research y Google DeepMind, el laboratorio británico de inteligencia artificial que el gigante tecnológico compró en 2014, CoDoC redujo la cantidad de interpretaciones de falsos positivos de las mamografías en un 25 %.

CoDoC es capacitados en los datos que contienen los análisis de imágenes médicas de las herramientas predictivas de IA y en la confianza de la herramienta en el análisis preciso de cada imagen. Los resultados se compararon con la interpretación de las mismas imágenes por parte de un médico humano y una confirmación posterior al análisis mediante biopsia u otro método que indicaba si se había descubierto un problema médico. El sistema aprende la precisión de la herramienta de IA en el análisis de imágenes y la precisión de sus estimaciones de confianza en relación con los médicos.

Luego, utiliza esta capacitación para juzgar si se puede confiar en un análisis de IA de un escaneo posterior o si debe ser verificado por un humano. “Si usa CoDoC con la herramienta de IA y los resultados de un radiólogo real, y CoDoC ayuda a decidir qué opinión usar, la precisión resultante es mejor que la persona o la herramienta de IA sola”, dice Alan Karthikesalingam de Google . Health UK, que trabajó en la investigación.

La prueba se ha repetido con diferentes conjuntos de datos de mamografía y radiografías para la detección de tuberculosis, en varios sistemas predictivos de IA, con resultados similares. «La ventaja de CoDoC es que es interoperable con una variedad de sistemas de IA patentados», dice Krishnamurthy «Dj» Dvijotham de Google DeepMind.

Es un desarrollo bienvenido, pero las mamografías y los controles de TB involucran menos variables que la mayoría de las decisiones de diagnóstico, dice Helen Salisbury de la Universidad de Oxford, por lo que será difícil expandir el uso de la IA a otras aplicaciones.

“Para los sistemas en los que no tiene posibilidad de influir, post-hoc, en lo que sale de la caja negra, parece una buena idea agregar el aprendizaje automático”, dice. «¿Eso acercará a la IA que estará allí con nosotros todo el día, todos los días para nuestro trabajo de rutina, no lo sé».

Los sujetos:

Deja un comentario